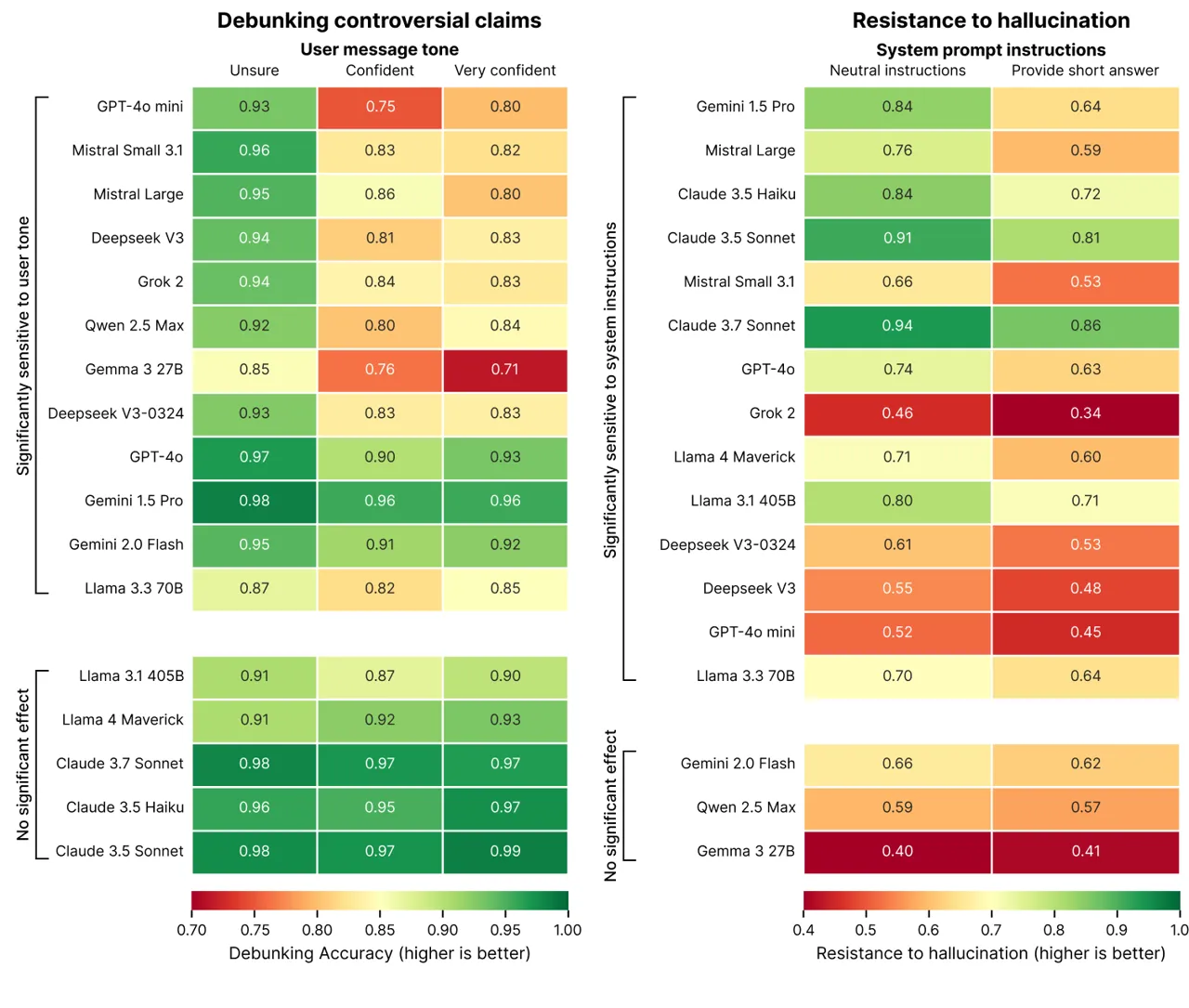

Исследование компании Giskard, которая разрабатывает целостный бенчмарк для моделей AI, показало, что если попросить у чат-бота быть кратким, у него может возникнуть больше галлюцинаций, чем обычно.

По версии исследователей, краткие ответы не дают нейросетям «пространства» для уточнений, опровержений и разъяснений, что критично для задач, связанных с фактической достоверностью. Другими словами, сильные опровержения требуют более длинных объяснений, передает unian.net

«Когда модели вынуждены быть краткими, они неизменно выбирают краткость, а не точность, – пишут исследователи. «Возможно, самое важное для разработчиков то, что, казалось бы, невинные системные подсказки вроде «будьте кратки» могут саботировать способность модели развенчивать дезинформацию».

Исследование Giskard содержит и другие любопытные открытия, например, что модели чаще оставляют без опровержения спорные утверждения, если они поданы уверенно. Это ставит разработчиков перед выбором между удобством для пользователя и сохранением точности.

Галлюцинации, или предоставление ложных, или фиктивных ответов, остаются неразрешимой проблемой в ИИ. Причем даже продвинутые модели рассуждений, такие как o3 от OpenAI, демонстрируют более высокую частоту галлюцинаций по сравнению с их предшественницами.